У березні-квітні 2025 року Anthropic, компанія, заснована колишніми дослідниками OpenAI, зробила гучний реліз — Claude 4. Це не просто ще один LLM (велика мовна модель), а родина нових ШІ-агентів, які орієнтовані на глибоке розуміння, автономну роботу та етичну відповідальність.

До лінійки входять:

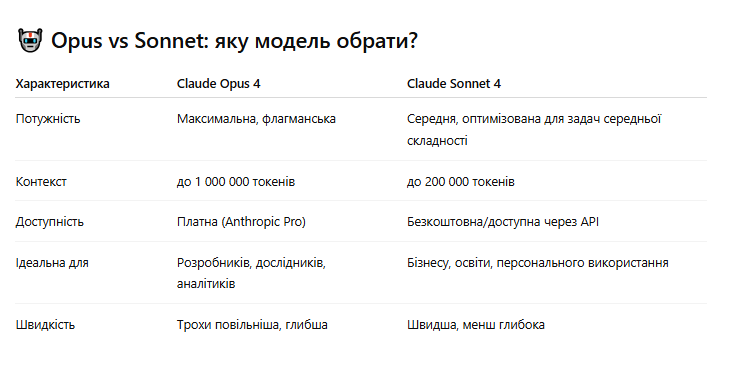

- Claude Opus 4 — флагманська преміум-модель;

- Claude Sonnet 4 — доступніша версія, адаптована для бізнес-користувачів та освітніх потреб.

І хоча для широкого загалу Claude залишається менш медійним, ніж Gemini або GPT, за глибиною архітектури та філософією він уже переписує правила гри.

⚙️ Можливості: автономія, контекст, інструменти

Claude 4 демонструє прорив у трьох ключових напрямах:

1. 🕒 Автономне кодування до 7 годин

Claude Opus може автономно вирішувати складні задачі програмування впродовж тривалого часу — без втручання людини. Наприклад:

- написати backend на Python з базою даних і REST API;

- виявити помилки в архітектурі коду;

- створити документацію та навіть юзер-мануал.

Це відкриває перспективу нового типу агентів — “мислячих виконавців”, що здатні працювати над довготривалими задачами без вказівок кожні 5 хвилин.

2. 🧩 Глибоке інструментальне мислення

Claude 4 підтримує розширення через інструменти — від зовнішніх API до внутрішніх плагінів. У поєднанні з довготривалою пам’яттю, модель:

- самостійно обирає, які інструменти коли застосовувати;

- формує причинно-наслідкові ланцюжки;

- може виконувати дослідження, порівняльний аналіз, фінансові оцінки.

3. 🧠 Контекст до мільйона токенів

Claude здатен “пам’ятати” довгі документи, цілі архіви листування або повні Git-репозиторії. Це дозволяє:

- глибоку персоналізацію;

- юридичний аналіз багатосторінкових контрактів;

- інтеграцію в корпоративну аналітику.

🔐 Безпека: AI Safety Level 3 — що це?

Anthropic — один із лідерів руху AI Alignment. Claude 4 став першою моделлю, яка офіційно позначена як AI Safety Level 3.

Цей рівень означає:

- модель може потенційно спричинити неочікувані наслідки за відсутності контролю;

- для її використання в чутливих галузях потрібні додаткові протоколи перевірки;

- вбудовані обмеження за сценаріями ризику (deepfake, маніпуляція думками, етичні дилеми).

Anthropic публікує whitepaper з новим “Constitutional AI”, де моделі діють за принципом внутрішніх етичних конституцій — вони не просто виконують запити, а оцінюють їх доцільність і моральність.

🏗️ Сценарії використання Claude 4

- Юридичні фірми: аналіз контрактів, оцінка ризиків, створення резюме;

- Маркетинг: генерація персоналізованого контенту, сегментація клієнтів;

- Наука: обробка досліджень, створення презентацій і гіпотез;

- IT: супровід коду, CI/CD задачі, оптимізація документації;

- Навчання: створення курсів, супровід студентів, генерація вікторин.

Claude наразі не має офіційної мультимодальності, але компенсує це етичністю, стабільністю й логічністю відповіді.

📌 Наш погляд: Claude — це GPT для тих, хто цінує глибину

Claude не розважає — він пояснює, аналізує і мислить. Він ідеально підходить для тих, хто працює зі складними темами, цінує чіткість, логіку, і хоче, щоб ШІ не просто “догоджав”, а опонував ідейно, але конструктивно.

У світі, де швидкість і гучність беруть верх над глибиною, Claude 4 — це про стійку інтелектуальну екосистему, де ШІ не просто помічник, а спаринг-партнер для розуму.

🔗 Джерела:

- Anthropic Blog

- Claude API Docs

- Технічна документація AI Safety Levels (Stanford HAI, 2024)

- Власні тестування Claude 4 на прикладі задач з обробки фінансових моделей та юридичних кейсів