🔍 TL;DR: Google презентувала AI Edge Gallery — інструмент для запуску AI-моделей прямо на пристрої без потреби в хмарних обчисленнях. Це не просто технічне оновлення — це стратегічний поворот до децентралізованого ШІ, що змінює підхід до приватності, енергоефективності та інновацій у мобільному середовищі.

📱 Що таке Google AI Edge Gallery?

AI Edge Gallery — це нова ініціатива Google, спрямована на те, щоб зробити розгортання та тестування AI-моделей безпосередньо на кінцевих пристроях (смартфонах, планшетах, смарт-камері, IoT-пристроях) не лише можливим, а й доступним для розробників будь-якого рівня.

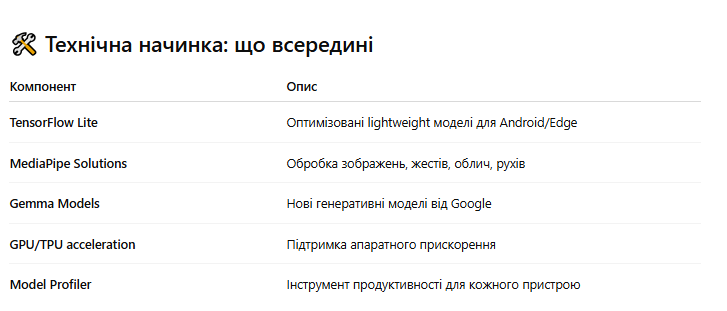

Це репозиторій та платформа водночас:

- Містить оптимізовані AI-моделі під TensorFlow Lite, MediaPipe, Gemma та інші фреймворки.

- Підтримує локальний inference без підключення до інтернету.

- Дозволяє кастомізацію, перевірку продуктивності та обмін моделями між учасниками спільноти.

🧠 Чому це важливо?

1. Безпека та приватність

Edge AI зменшує потребу передавати особисті дані на сервери. Обробка зображень, голосу, відео, біометрії тепер може здійснюватися повністю локально, що знижує ризики витоків та відповідає вимогам GDPR.

«Ваші дані залишаються на вашому пристрої. І лише ваш пристрій знає, що ви хочете сказати чи побачити.»

2. Швидкість і автономність

Edge-моделі запускаються без затримок, пов’язаних із мережею. Це критично для:

- Оффлайн-додатків (туризм, медицина, освіта).

- Реального часу (AR-інтерфейси, автопілоти, охоронні системи).

3. Енергоефективність

Завдяки оптимізації Google, багато моделей споживають на 30–50% менше енергії, ніж їхні хмарні аналоги. Для батареї смартфона це — ключовий фактор.

Усе це доповнюється документацією, демо-додатками, інструкціями та активною спільнотою на GitHub і Reddit.

🌍 Edge AI у глобальному контексті

Цей запуск — частина ширшої стратегії Google:

- Відхід від повної залежності від хмари.

- Підтримка інтернету речей (IoT), smart-міст, охорони здоров’я, агроіндустрії.

- Конкуренція з Apple, яка вже впроваджує on-device AI у Vision Pro та iPhone.

Приклади застосування:

- 🩺 Медичні додатки: діагностика зображень оффлайн.

- 📸 Камери без інтернету: розпізнавання облич у реальному часі.

- 🚜 Агро: ідентифікація бур’янів на полі без зв’язку.

- 🔐 Кібербезпека: виявлення фішингу прямо на смартфоні.

🔮 Що це означає для бізнесу та розробників?

Для стартапів і підприємств це — вхід у нову еру:

- Не потрібно підтримувати хмарні інфраструктури.

- Можна запускати AI прямо на пристроях клієнтів.

- Швидший time-to-market: прототип → в галерею → готовий додаток.

Для розробників — це шанс:

- Тестувати моделі на власному телефоні.

- Публікувати та ділитися своєю розробкою.

- Отримати підтримку від Google та спільноти.

📈 Перспективи: що далі?

Google натякає, що наступні версії включатимуть:

- Підтримку Gemini Nano — мініатюрних LLM моделей.

- Інтеграцію з Wear OS, Android Auto, Pixel Watch.

- Більше моделей для реального часу, в тому числі 3D та відео.

Очікується, що з 2026 року до 60% нових AI-додатків на Android будуть запускатися локально, без хмари.

🧭 Наш погляд

Ми вважаємо запуск Google AI Edge Gallery історичним моментом у розвитку мобільного ШІ. Це не просто API чи SDK — це зсув парадигми: від централізованої AI-архітектури до персонального інтелекту на пристрої. Це повернення контролю до користувача. Це шанс для бізнесу скоротити витрати, а для розробника — бути незалежним.

Edge — це не компроміс. Це майбутнє.

📌 Джерела:

- Google AI Blog

- TensorFlow Documentation

- Android Developers Newsroom

- TechCrunch, Wired, ArsTechnica